Alibaba Desafia Google e OpenAI: Conheça o Qwen2.5-Omni, a IA de Código Aberto Que Vê, Ouve e Fala

A competição no mundo da Inteligência Artificial (IA) acaba de ganhar mais um participante importante. Enquanto o Gemini do Google e a OpenAI têm nos impressionado com suas capacidades multimodais – entendendo imagens, vídeos e áudios junto com textos – a equipe Qwen da Alibaba lançou silenciosamente uma possível bomba: o Qwen2.5-Omni. Esta não é apenas mais uma grande ferramenta de linguagem; ela é apresentada como uma IA multimodal "omnidirecional" criada para perceber o mundo de forma mais parecida com a nossa. Ela processa textos, imagens, áudios e vídeos, respondendo não apenas com texto, mas com fala sintetizada em tempo real.

Talvez a parte mais inovadora? A Alibaba tornou aberta (open-source) a versão de 7 bilhões de parâmetros, Qwen2.5-Omni-7B, sob uma licença Apache 2.0. Essa ação pode colocar ferramentas de IA multimodais sofisticadas diretamente nas mãos de desenvolvedores e empresas em todo o mundo, gratuitamente para uso comercial. É uma jogada ousada, desafiando os sistemas fechados de seus principais concorrentes.

O Que Tem Dentro? A Arquitetura "Pensador-Falador"

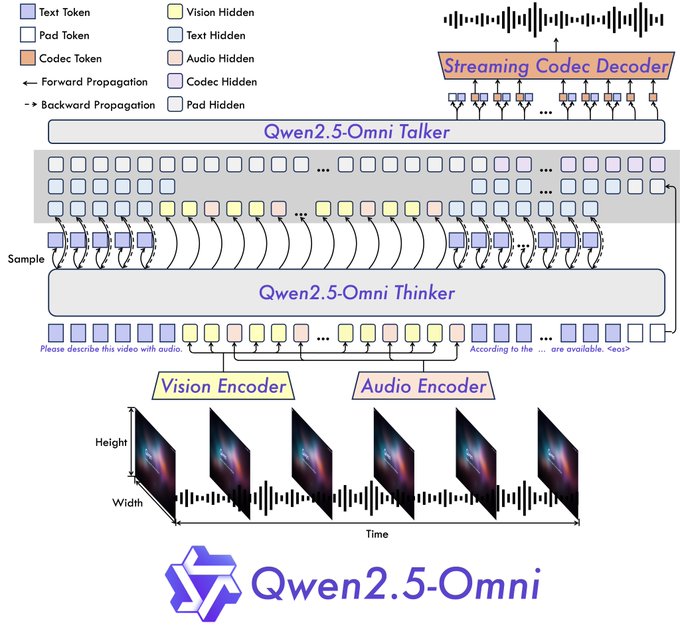

A Alibaba não apenas adicionou sentidos a uma ferramenta de linguagem já existente. Eles apresentaram uma nova arquitetura "Pensador-Falador".

- O Pensador: Este componente age como o cérebro. Ele recebe as diversas informações – textos, imagens, sons – e as processa para entender o contexto e gerar representações semânticas de alto nível, juntamente com a resposta principal em texto. Ele usa codificadores específicos para áudio e visão para extrair as características relevantes.

- O Falador: Funcionando como a boca e as cordas vocais, o Falador recebe as informações semânticas e o texto do Pensador em tempo real. Ele então sintetiza isso em unidades de som (tokens) discretas, gerando um fluxo de fala com som natural junto com o texto escrito.

Este design completo é crucial para permitir experiências interativas em tempo real. A arquitetura suporta entradas divididas em partes e saídas imediatas, buscando conversas que pareçam mais uma chamada de vídeo do que um bate-papo por turnos.

Além disso, o Qwen2.5-Omni incorpora uma nova técnica de posicionamento chamada TMRoPE (Time-aligned Multimodal RoPE). Isso resolve especificamente um problema difícil: sincronizar com precisão os quadros de vídeo com seus segmentos de áudio correspondentes ao longo de uma linha do tempo compartilhada. Acertar isso é essencial para entender as ações e a fala dentro do conteúdo do vídeo corretamente.

Alegações de Desempenho vs. Testes no Mundo Real: Sentidos Impressionantes, Inteligência Questionável?

A Alibaba afirma que o Qwen2.5-Omni alcança resultados de ponta no OmniBench, um teste criado para tarefas multimodais integradas. Eles também informam que ele supera modelos de tamanho semelhante, incluindo concorrentes de código fechado como o Gemini 1.5 Pro do Google em certas tarefas, e até mesmo modelos especializados de modalidade única de sua própria linha (como o Qwen2.5-VL-7B para visão e o Qwen2-Audio).

As demonstrações oficiais e os testes iniciais dos usuários mostram um quadro fascinante, embora misto:

- O Lado Bom – Habilidade Multimodal:

- Visão: Ele identificou com precisão "comportamento suspeito" em uma imagem simulada de feed de segurança, fornecendo uma classificação e raciocínio corretos.

- Vídeo: Dado um vídeo de dança, ele forneceu uma descrição detalhada da roupa do dançarino, movimentos e cenário.

- Áudio: Ele resumiu corretamente os passos para fazer Carne de Porco Refogada com Molho de Soja (Red Braised Pork) a partir de uma receita de áudio enviada.

- Interação: A saída simultânea de texto e voz com som natural (lidando bem com inglês/chinês misturado) é rápida e fluida, criando uma sensação genuinamente conversacional. As demonstrações mostram videochamadas onde a IA descreve os arredores, atua como um assistente de receita guiado por voz, critica rascunhos de músicas, analisa esboços e até ensina problemas de matemática passo a passo a partir de uma foto.

- O Lado Ruim – Falhas de Raciocínio e Obstáculos Práticos:

- Falhas Lógicas Básicas: Apesar de seu processamento sensorial avançado, o modelo de demonstração de 7B tropeçou em tarefas de raciocínio simples. Questionado sobre "Qual é maior, 6,9 ou 6,11?", ele afirmou incorretamente que 6,9 é menor. Questionado sobre quantas letras 'r' existem em "strawberry", ele respondeu duas (existem três). Isso sugere uma possível lacuna entre a capacidade de percepção e o raciocínio cognitivo, pelo menos nesta versão acessível.

- Intensidade de Recursos: Alguns usuários que tentaram executar o modelo localmente relataram requisitos significativos de VRAM, com uma instância citando um erro de falta de memória em uma configuração de VRAM de 100 GB para um vídeo de 21 segundos. Outros notaram erros com imagens maiores e tempos de geração lentos (minutos por resposta), indicando que a implantação eficiente pode exigir otimização ou configurações de hardware específicas.

- Idioma e Personalização: Embora a saída de voz em inglês e chinês seja forte, os usuários notaram limitações com outros idiomas como espanhol e francês. A saída de voz atualmente espelha o texto; mais opções de personalização seriam benéficas para aplicações específicas. A acessibilidade para usuários não especialistas também foi apontada como necessitando de melhorias.

A Jogada de Código Aberto: Democratizando a IA Multimodal?

A decisão da Alibaba de abrir o código do Qwen2.5-Omni-7B sob a licença Apache 2.0, comercialmente permissiva, é talvez o aspecto mais estrategicamente significativo deste lançamento.

- Redução de Barreiras: Ele permite que startups, pesquisadores e até mesmo empresas estabelecidas experimentem e implementem IA multimodal avançada sem os custos exorbitantes de API ou taxas de licenciamento associadas a modelos fechados. Isso pode estimular a inovação em áreas como:

- Ferramentas de acessibilidade: IA que pode descrever o mundo para deficientes visuais.

- Educação: Tutores interativos que podem ver o trabalho de um aluno e ouvir suas perguntas.

- Assistência Criativa: Ferramentas que criticam arte visual, música ou escrita com base em múltiplas entradas.

- Dispositivos Inteligentes: Permitir uma interação mais natural com wearables (como o conceito de óculos inteligentes mencionado pelos usuários) ou assistentes domésticos.

- Pressão Competitiva: Esta medida desafia diretamente os modelos de negócios da OpenAI e do Google, potencialmente forçando-os a reconsiderar seus preços ou oferecer versões mais acessíveis de seus próprios modelos de ponta. O comentário do usuário chamando isso de "OpenAI verdadeiro" reflete um segmento da comunidade de desenvolvedores faminto por ferramentas poderosas e abertas.

- Construção de Ecossistema: Para a Alibaba, isso pode ser uma jogada para construir um ecossistema de desenvolvedores em torno de seus modelos Qwen, promovendo uma adoção mais ampla e potencialmente impulsionando o uso de sua plataforma de nuvem onde o modelo também está hospedado.

A Conclusão: Um Passo Poderoso, Mas a Jornada Continua

O Qwen2.5-Omni é inegavelmente um avanço significativo na IA multimodal, particularmente impressionante por sua integração perfeita de diversas entradas e saída de texto e fala em tempo real dentro de uma nova arquitetura. A abertura do código do modelo 7B é uma jogada importante que pode impactar significativamente o cenário da IA, capacitando desenvolvedores e empresas em todo o mundo.

No entanto, os testes iniciais destacam uma realidade crucial: a percepção sensorial avançada não se traduz automaticamente em raciocínio perfeito ou implantação sem esforço. Os erros lógicos observados e as demandas de recursos relatadas mostram que ainda há obstáculos a serem superados.

Para empresas e investidores, o Qwen2.5-Omni representa tanto uma oportunidade quanto um ponto de observação. A oportunidade reside em alavancar esta ferramenta poderosa e acessível para a inovação. O ponto de observação é observar como o modelo amadurece, como a comunidade aborda suas limitações e como os concorrentes respondem a este desafio de código aberto. A Alibaba jogou uma carta forte; os próximos movimentos no jogo de alto risco da IA são aguardados ansiosamente.

Recursos:

- Demo: https://huggingface.co/spaces/Qwen/Qwen2.5-Omni-7B-Demo

- Experiência de Chat Qwen: https://chat.qwen.ai/

- GitHub: https://github.com/QwenLM/Qwen2.5-Omni

- Modelo Hugging Face: https://huggingface.co/Qwen/Qwen2.5-Omni-7B

- Relatório Técnico: https://github.com/QwenLM/Qwen2.5-Omni/blob/main/assets/Qwen2.5_Omni.pdf

- Postagem no Blog: https://qwenlm.github.io/blog/qwen2.5-omni/